|

Klaus Fröhlich-Gildhoff & Rieke Hoffer

[Forum Gemeindepsychologie, Jg. 25 (2020), Ausgabe 1]

Zusammenfassung

Psychologisches und Pädagogisches Handeln sollte wissenschaftlich begründet sein - dazu ist Wissen über mögliche Wirkungen bestimmter Interventionen und Handlungsweisen nötig. Der sog. "Goldstandard" der experimentellen, randomisierten Kontrollgruppendesigns (RCT Designs) auf Basis des medizinischen Modells ist allerdings für die Erfassung von Wirkungen in komplexen Praxiszusammenhängen nicht geeignet. In diesem Beitrag wird die Begrenztheit der RCT Designs beschrieben und es werden vier Alternativen zur Erfassung von Wirkungen und Wirkzusammenhängen (Prinzipien der Implementationsforschung, Umsetzungsindex, qualitative Methoden in quasiexperimentellen Designs, kontrollierte Einzelfallstudien) dargestellt sowie zentrale Kriterien einer gegenstandsangemessenen Wirkungsforschung unter Praxisbedingungen abgeleitet.

Schlüsselwörter: Wirkungsforschung, pragmatic controlled designs, Implementationsforschung, Praxisforschung, Evaluationsforschung

Summary

Beyond the gold standard - Methodical and methodological challenges of impact research under practical conditions

Psychological and pedagogical acting should be founded scientifically. Therefore knowledge about effects or outcomes of recent interventions is needed. The 'gold standard' of randomized controlled trials (RCT designs), based on the medical model, is not suitable for research in complex contexts of pedagogic and psychologic practice. This article describes the limits of RCT designs and shows four alternatives to determine the effects of psychologic and pedagogic interventions (principles of implementation research, transformation index, qualitative methods in semi-experimental designs, controlled single studies). Finally, central criteria of an adequate effectiveness and evaluation research under practice conditions are derived.

Keywords: effectiveness research, pragmatic controlled designs, implementation research, research under practice conditions, evaluative research

1 Einführung

Im Bereich psychotherapeutischer, aber auch präventiv ausgerichteter Interventionen, gilt zunehmend das Primat der "Evidenzbasierung"; Finanzierungen von Maßnahmen sind an den Nachweis der "Wirksamkeit" gebunden. Diese Entwicklung hat auch spätestens mit der Etablierung der empirischen Bildungsforschung im breiten Feld der Pädagogik Einzug gehalten: Pädagogisches Handeln sollte wissenschaftlich begründet sein und sich im optimalen Fall an empirisch nachgewiesenen bzw. rekonstruierbaren Wirkungen oder Wirkungszusammenhängen ausrichten (zu diesem Diskurs vgl. z.B. Fröhlich-Gildhoff & Nentwig-Gesemann, 2008; Albus & Micheel, 2012; Hoffmann, Kubandt, Lotte, Meyer & Nolte, 2014).

Dabei hängen die Themen "Wirkungsorientierung" und "Wirksamkeitsforschung" in sozialwissenschaftlichen, gesundheitswissenschaftlichen und psychologischen Zusammenhängen, v.a. den entsprechenden Arbeitsfeldern/Praktiken, mit mehreren grundlegenden Fragen zusammen:

Wie sind Wirkungen und Wirksamkeitsfaktoren zu beschreiben und empirisch zu erfassen? Klassischerweise erfolgt hier der Verweis auf die in Medizin und Psychologie etablierten Designs nach dem Goldstandard randomisierter Experimentalstudien (RCT-Designs, Otto, 2007; Wirtz, 2014), die jedoch insbesondere beim Transfer in die Praxis deutlich ihre Grenzen finden und aus methodologischer Perspektive umstritten sind (s.u.).

Wie lassen sich die in systematischen und kontrollierten Studien erfassten Wirkungszusammenhänge auf die ‚alltägliche' pädagogische, psychologische und Präventions-Handlungspraxis so transferieren und transformieren, dass sie dieser Praxis angemessen sind? Handlungsprozesse in diesen Feldern sind i.d.R. an Interaktionen gebunden. Diese sind wiederum dadurch gekennzeichnet, dass sie sich nicht (vollständig) normieren und standardisieren lassen; das interaktionelle Geschehen und das Handeln der Professionellen entfaltet seine Wirkung stets mit einer gewissen Eigendynamik und Eigensinnigkeit (vgl. Honig, 2002) und ist grundlegend durch ein gewisses Maß von Unbestimmtheit bzw. "Ausgangswahrscheinlichkeit" gekennzeichnet. Trotz der entsprechend notwendigen Flexibilität müssen die Professionellen wissenschaftlich fundierte Erkenntnisse zur Handlungsplanung, -durchführung und -reflexion zur Verfügung haben (z.B. Fröhlich-Gildhoff, Nentwig-Gesemann et al., 2014).

Wie werden die Interessen der AdressatInnen, der Kinder und Familien berücksichtigt? Diese haben ja schon aus ethischer Sicht ein Anrecht darauf, dass als wirksam identifizierte Maßnahmen - z.B. evidenzgesicherte Formen der Sprachförderung - in der Praxis bestmöglich und passgenau umgesetzt werden.

Führt evidenzbasiertes Handeln zu mehr Effektivität und damit Wirtschaftlichkeit - wie dies auch unter einer ökonomischen Perspektive erwartet wird? Diese im Feld der Kinder- und Jugendhilfe schon länger bestehende Diskussion (Stichwort: "Neue Steuerung", BMFSFJ, 2000; Flösser & Otto, 1996) hat auch die Pädagogik erreicht: So kritisieren bspw. Ahrbeck et al. (2016) die Deformation der Pädagogik durch die - mit dem Primat der Evidenzbasierung einhergehende - Ökonomisierung. Die Verbindung zwischen "Wirksamkeits"nachweisen und Finanzierbarkeit von Maßnahmen gehört zumindest im Bereich der Psychotherapie in den Strukturen des Gesundheitswesens zum Alltag (vgl. hierzu auch die Diskussionen um die Zulassung von Therapieverfahren).

In diesem Beitrag wird im Besonderen auf die erste Frage eingegangen. Dabei werden zunächst die Grenzen der klassischen (randomisierten) Experimentalforschung für die Erfassung von Wirkungen unter komplexen Praxis-/Realbedingungen beschrieben. Danach werden vier Möglichkeiten aufgezeigt, wie die Wirkungen von Interventionen erforscht werden können; ein Schwerpunkt wird dabei auf die Erfassung des Zusammenhangs von Veränderungen über die Zeit einerseits und die sorgfältige Analyse des Umsetzungsprozesses andererseits gelegt.

2 Der Goldstandard und seine Grenzen

Nach wie vor gelten experimentelle, randomisierte Kontrollgruppendesigns (RCT-Studien) vielfach als "Goldstandard" der Evaluation der Wirkungen von Interventionen und als zentrales Kriterium der Evidenzbasierung (z.B. Wirtz, 2014). Im Unterschied zur klassischen naturwissenschaftlichen, pharmakologischen oder auch psychologisch-experimentellen Grundlagenforschung handelt es sich bei Interventionen in humanwissenschaftlichen Kontexten, wie der (Früh-)Pädagogik, der Psychotherapie oder der Präventionsforschung, i.d.R. um komplexe Interventionen unter Real- d.h. Praxisbedingungen. Unter diesen Bedingungen herrschen eine Vielzahl von Einflüssen vor, die als Variablen in ihrer Gesamtheit kaum zu erfassen sind, ja z.T. erst im Implementationsprozess deutlich werden.

Das den RCT-Studien zugrunde liegende "medical model" (Wampold, 2001) kann der Komplexität sozialen Geschehens in diesen Kontexten nur begrenzt gerecht werden; das Kontrollieren von ‚reinen' Ausgangs- und Ergebnisbedingungen (abhängige Variablen) vor und nach der Durchführung einer größtmöglich standardisierten Intervention sowie die gänzliche Elimination von "Störbedingungen" ist in Realsituationen sozialen Handelns nicht möglich.

Bereits Holzkamp (1972, 1977) hat auf eine mögliche Folge und Gefahr der "wissenschaftlichen Beliebigkeit" hingewiesen, mittels derer aus dem komplexen Untersuchungsgegenstand "soziale Realität" Teile herausgeschnitten und dann isoliert in Form von Variablen in Experimentalsituationen untersucht werden - als ein Resultat hat er eine abnehmende Relevanz von (in diesem Falle: psychologischer) Forschung zum Erfassen und Erklären von (sozialen) Phänomenen und das zusammenhanglose Nebeneinander-Stehen von Theorien oder Theorieteilen beschrieben.

Im Einzelnen stoßen RCT-Studien an folgende Grenzen: - RCT-Studien erfordern eine homogene Gruppenbildung, um Vergleiche zu ermöglichen - eine solche ist unter Praxisbedingungen in der Regel nicht gegeben (Kazdin, 2011; Wampod, 2001).

- Die geforderte Standardisierung/Manualisierung der Intervention ist unter Praxisbedingungen nicht zu realisieren: Das manualbasierte, gleichartige Vorgehen ("treatment fidelity") widerspricht der seit langem vorliegenden Erkenntnis, dass Fachlichkeit gerade darin gesteht, eine Intervention auf die jeweilige Zielgruppe zu adaptieren ("Passgenauigkeit"; z.B. Fröhlich-Gildhoff et al., 2014; Hasselhorn et al., 2014).

- Die geforderte Randomisierung ist häufig ethisch nicht zu vertreten und auch das Vergleichsgruppendesign stößt an Grenzen: So dürfen z.B. im Bereich der "Frühen Hilfen" Kinder mit besonderem Unterstützungsbedarf nicht einer "Wartelistenkontrollgruppe" zugeordnet werden - in diesem Entwicklungsabschnitt müssen Hilfen unmittelbar erfolgen. Bei Wartelisten-Kontrolldesigns kümmern sich Mitglieder der Kontrollgruppe zudem oftmals während der Wartezeit um Information oder Unterstützung (Kornberger & Yanagida, 2017).

- Einige Faktoren, wie z.B. drop-out-Raten aufgrund des hohen Grades an Freiwilligkeit oder des Wegzugs von Familien, sind in Studien unter Realbedingungen schlecht zu kontrollieren.

- Das RCT-Modell folgt einem linearen Modell: Es werden statistische Auswertungen von Gruppenvergleichen über mehrere Messzeitpunkte gemacht. Viele in Psychologie und Pädagogik relevante Phänomene sind jedoch nicht linearer Natur. Somit werden Prozessdynamiken nicht erfasst und Fragen wie "Was passiert, damit es zu Veränderungen kommt? Welche Faktoren wirken dynamisch zusammen?" werden nicht beantwortet (z.B. Kazdin, 2011).

Aufgrund dieser Probleme kommt bspw. Kolip (2006, S. 236) zu dem Schluss, dass "randomisierte, kontrollierte Studien zwar einem methodisch hohen Standard folgen, sich aber nur für wenig komplexe Fragestellungen und mit klar definierten Endpunkten eignen". Noch etwas schärfer formuliert Ziegler (2010, S. 164): "Die Kausalbeschreibungen von RCTs [gelten] nur für die tatsächlich geprüften Kontexte und Programmgestaltungen. Eine Übertragung ihrer Ergebnisse auf andere Kontexte und Programmgestaltungen ist nicht möglich. In Struktur und Ausprägung veränderte Rahmenbedingungen machen die Aussagen der Kausalbeschreibung als ‚objektive' Entscheidungsgrundlage wertlos".

Porszolt et al. (2013, S. 308) fassen die Bedenken wie folgt zusammen: "Explanatory trials can demonstrate efficacy [Wirksamkeit unter kontrollierten, idealen Bedingungen], i.e. whether a principle would work under ideal conditions, but it cannot demonstrate effectiveness [Wirkungsweise; Wirksamkeit unter Real-/Alltagsbedingungen], i.e. whether the same principle would also work under real world conditions". Es wird daher ein "Pragmatic Controlled Design" (PCT) vorgeschlagen, bei dem die Komplexität sozialer Sachverhalte aufgenommen und berücksichtigt wird. Somit sollen Person-Faktoren wie z.B. Motivation, Erwartungen oder Akzeptanz, aber auch die Kooperation zwischen demjenigen, der die Intervention "einbringt" (z.B. Trainer), und demjenigen, der sie "erhält", explizit einbezogen und bei der Analyse von Gruppendaten berücksichtigt werden. "By definition of the inclusion and exclusion criteria, the number of confounders is reduced in an explanatory trial in contrast to a pragmatic trial in which the access is not limited by these criteria” (ebd., S. 311; s.a. Di Blasi et al., 2001). PCT-Designs sind also durch ein breites Erfassen der in den Realbedingungen vorhandenen Variablen gekennzeichnet, ,Abweichungen' bei der Realisierung der Intervention werden genau protokolliert und Variabilität wird zum Erklären der gefundenen Effekte genutzt.

Die Betrachtung der Grenzen einer Wirkungsforschung mittels des RCT-Designs bedeutet allerdings nicht, dass es keine Kern-Anforderungen an die Untersuchung der Wirkung(en) von Maßnahmen bzw. Interventionen - insbesondere unter Praxisbedingungen - gibt. Aus der Literatur zur (Wirkungs-)Evaluation (z.B. Bortz & Döring, 2006; Fröhlich-Gildhoff, 2012; Stockmann, 2006) lassen sich zentrale Anforderungen an entsprechende Studien und Designs zusammenfassen: - eine Intervention oder Handlungspraxis ist über mehrere Messzeitpunkte zu beobachten;

- es ist eine Vielfalt von Methoden einzusetzen, um verschiedene Zugänge zum Untersuchungsgegenstand zu ermöglichen; zu bevorzugen sind mixed methods Designs (Cresswell, 2003);

- es sind verschiedene Perspektiven (Selbstbeobachtung, Fremdbeobachtung) zu berücksichtigen;

- es muss eine Verbindung von Prozessdaten und Ergebnissen hergestellt werden können.

Im Folgenden sind methodisch kontrollierbare Alternativen für eine aussagekräftige Wirkungsforschung jenseits der RCT-Designs aufgeführt.

3 Möglichkeiten und Beispiele für Wirkungsforschung jenseits des Goldstandards

3.1 Implementationsforschung

Die Implementationsforschung - also die "Beschreibung und Analyse von Prozessen bei der Umsetzung von Konzepten oder Programmen" (Petermann, 2014, S. 122) - hat eine gewisse Tradition im Rahmen der Klinischen Psychologie/Psychotherapie, der Präventionsforschung (Übersicht: Beelmann & Karing, 2014) und auch im Bildungsbereich (Gräsel & Parchmann, 2004; Hasselhorn et al., 2014). Die Kombination von prä/post-Messungen mit Daten über den Implementationsprozess ermöglicht Aussagen über Wirkungen und wirkungsrelevante Faktoren.

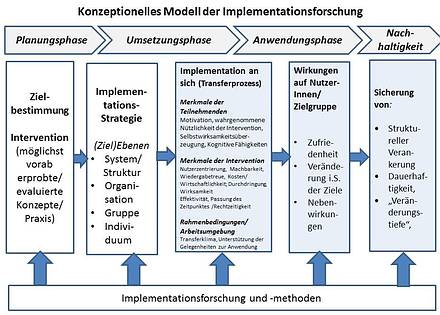

In Anlehnung an das Modell von Proctor et al. (2009) sowie das Transfermodell von Baldwin & Ford (1988), ergänzt durch empirisch abgesicherte Faktoren zu Transferprozessen nach Grossmann & Salas (2011, vgl. hierzu Hoffer, 2014), lassen sich vier Phasen im Implementationsprozess unterscheiden: - In der Planungsphase wird eine - möglichst vorab empirisch ‚abgesicherte' - Intervention ausgewählt; es wird eine entsprechende Strategie der Implementation eingeschlagen. Eine wichtige Voraussetzung hierfür ist "eine möglichst präzise Problembestimmung und die Entscheidung über den intendierten … Interventionsbereich" (Mittag, 2014, S. 51). Hierbei lassen sich wiederum verschiedene Ebenen der Implementation identifizieren: ganze Systeme oder Strukturen (z.B. bei einer Trägerorganisation mehrerer Kindertageseinrichtungen), einzelne Organisationen (z.B. das Team einer Kindertageseinrichtung), eine bestimmte Gruppe oder Einzelpersonen (z.B. die Qualifizierung einzelner Fachkräfte).

- In der Umsetzungsphase spielen Merkmale der Intervention an sich wie Nutzerzentrierung, Machbarkeit, Passung des Zeitpunktes sowie Wirksamkeit und Effektivität eine Rolle. Als zweiter Aspekt sollten die Merkmale der Teilnehmenden berücksichtigt werden wie z.B. die Motivation (vgl. Grossman & Salas, 2011, S. 109), hohe Selbstwirksamkeitsüberzeugungen, die Überzeugung von der Nützlichkeit der Intervention und als latenter Faktor die kognitiven Fähigkeiten - all dies hat Einfluss auf den Erfolg der Implementation und den Transfer. Als weiterer Faktor in der Umsetzungsphase sollten bei der Implementierung die Rahmenbedingungen berücksichtigt werden. Hierbei spielt z.B. das Transferklima in der Arbeitsumgebung eine große Rolle, d.h. die Anreize und Möglichkeiten am Arbeitsplatz, neu Gelerntes anzuwenden. Zudem bieten Folgeveranstaltungen einen weiteren Anreiz, das Gelernte tatsächlich umzusetzen.

- Das führt dann zur Anwendungsphase und somit zum eigentlichen Transfer, zum Übertrag von "neu Gelerntem aus dem Lernkontext in den realen Anwendungskontext" (Hense & Mandl, 2011, S. 250). Hierfür spielen selbstverständlich alle Rahmenbedingungen der Implementation weiter eine Rolle, es stellt sich tatsächlich nun die Frage, wie groß die Zufriedenheit mit der Implementation ist und wie die Zielerreichung selber einzuschätzen ist. Dabei sind verschiedene Perspektiven - im Besonderen die der AnwenderInnen - zu beachten.

- Im nächsten Schritt, der Phase der Nachhaltigkeit, stellt sich abschließend die Frage, wie lange die Veränderungen aufrechterhalten und dauerhaft in die Alltagspraxis integriert werden können.

Proctor et al. (2009) differenzieren die Ergebnisse der Implementation nach der Analyse des Implementationsprozesses an sich (einschließlich der dabei relevanten Faktoren), den Wirkungen der implementierten Dienstleistung/des Programms sowie den (Aus-)Wirkungen auf die Zielgruppe bzw. die NutzerInnen.

Das o.g. Phasenmodell lässt sich mit diesem Modell von Proctor et al. (2009) wie folgt verbinden:

- Abbildung 1: Konzeptionelles Modell der Implementationsforschung

Petermann (2014, S. 123f.) formulierte in Anlehnung an Grimshaw et al. (2006), Michie et al. (2009) sowie Proctor et al. (2009) acht "Implementationsoutcomes", die eine Aussage über den Erfolg einer Implementationsstrategie erlauben soll(t)en; diese Kriterien werden im Folgenden durch weitere Literaturhinweise sowie durch Ergebnisse des Überblicks über insgesamt 81 einschlägige Studien von Durlak und DuPree (2008) ergänzt: - Akzeptanz der Intervention bei den Beteiligten/Zielgruppen; hierzu gehören auch die wahrgenommene Attraktivität (Beelmann & Karing, 2014, S. 132) und der wahrgenommene bzw. erwartete Wert der Intervention (Hasselhorn et al., 2014). Zum Erzielen von Akzeptanz sind ein transparentes Vorgehen, eine offene Kommunikation und partizipative Entscheidungsprozesse wesentlich unterstützend (Durlak & DuPree, 2008).

- Übernahme der Intervention in die Praxis der Zielgruppe; hierbei haben der konkrete Bedarf der Zielgruppe (Durlak & DuPree, 2008) und die Übereinstimmung zwischen diesen und den Programmzielen (Mittag, 2014) sowie schnelle, als "Erfolg" wahrnehmbare Veränderungen eine Bedeutung (Fröhlich-Gildhoff, Kerscher-Becker, et al., 2014).

- Angemessenheit, also "die wahrgenommene Passung, Aktualität und Kompatibilität der Intervention (…) für ein bestimmtes Setting, einen Anbieter oder Nutzer" (Petermann, 2014, S. 124). Durlak & DuPree (2008, S. 337) beschreiben in diesem Zusammenhang den Faktor der "compatibility (contextual appropriateness, fit, congruence, match)". Ein wichtiger Aspekt ist die "Dosierung" (Mittag, 2014), also Intensität, Umfang und Dauer der Intervention.

- Machbarkeit oder Realisierbarkeit der Intervention im angezielten Setting. Eine Intervention muss - auch wenn sie zum Setting passt - zum Umsetzungszeitpunkt realisierbar und praktikabel sein. Wenn sich eine Einrichtung bspw. in generellen Umstrukturierungsprozessen befindet, kann es eine Überforderung darstellen, wenn ein neues Projekt (z.B. zur Sprachförderung) implementiert werden soll.

- Verhältnis von Wiedergabetreue und Passgenauigkeit; dabei wird die Genauigkeit der Umsetzung des - im besten Falle manualisierten - Curriculums unter pragmatischen Gesichtspunkten der Passgenauigkeit, also der Adaptation an die Zielgruppe untergeordnet: Es "zeigte sich, dass nicht generell eine hohe Umsetzungsgenauigkeit mit besseren Programmergebnissen einhergeht, sondern dass bei der Umsetzung von Programmen zum Teil Abweichungen notwendig waren, um eine Maßnahme an die Gegebenheiten … der Institution anzupassen" (Petermann, 2014, S. 127, ebenso: Beelmann & Karing, 2014; Mittag, 2014); Durlak und DuPree (2008) sprechen in diesem Zusammenhang von "adaptability".

- Kosten/Wirtschaftlichkeit: Der Implementationsprozess einer Maßnahme muss einerseits finanziell solide abgesichert sein, andererseits sollten die hierfür eingesetzten Kosten zumindest mittelfristig wirtschaftlich gerechtfertigt sein.

- Durchdringung, also die "Implementationstiefe" (Hasselhorn et al, 2014, S. 142) bzw. breite "Integration einer Maßnahme in die betreffende Institution" (Petermann, 2014, S. 125; "integration of new programming", Durlak & Du Pree, 2008, S. 337).

- Nachhaltigkeit: Die angezielten Veränderung durch die Maßnahme sollen über die eigentliche Implementationsdauer hinaus wirksam sein.

Zusätzlich zu diesen acht Faktoren finden sich in der einschlägigen Literatur weitere bedeutsame Einflussgrößen auf den möglichen Erfolg der Implementation einer Intervention: - "Merkmale der einzelnen Einrichtung" (Hasselhorn et al., 2014, S. 144). Folgende relevante Institutionsfaktoren lassen sich identifizieren: das Institutionsklima ("positive work climate", Durlak & DuPree, 2008, S. 337), Offenheit für den Wandel ("openess to change", ebd.), Kooperation und Unterstützung im Team, die Unterstützung und enge Begleitung durch die Leitung, relevante unterstützende AkteurInnen im Team ("program champion, internal advocate", Durlak & DuPree, 2008, S. 337; "change agents", Hasselhorn et al., 2014, S.146), ausreichende personelle und finanzielle Ressourcen, Transferunterstützung durch das Umfeld (z.B. den Träger), dauerhafte Information und Transparenz über die Maßnahmen sowie die Zentrierung auf die jeweilige Intervention/Maßnahme (keine "Parallelprojekte") (vgl. Beelmann & Karing, 2014; Fröhlich-Gildhoff, Kerscher-becker, et al., 2014; Gräsel & Parchmann, 2004; Hasselhorn et al., 2014).

- "Merkmale der pädagogischen Fachkräfte" bzw. Anwender/Zielgruppe (Hasselhorn et al., 2014, S. 144); hierzu zählen vor allem Motivation, Ausgangskompetenz, persönliche Überzeugungen und Selbstwirksamkeitserwartungen (Durlak & DuPree, 2008) sowie die "Responsivität" (Mittag, 2014, S. 53) derjenigen, die Zielgruppe der Intervention sind.

- Rolle der Person und wahrgenommene Kompetenz der UmsetzerInnen/ReferentInnen: Die Bedeutung der Person, der Qualifikation und der Kompetenz, aber auch der Motivation von WeiterbildnerInnen für den Fort-/Weiterbildungserfolg konnte vereinzelt in anderen Untersuchungen nachgewiesen werden (Überblick z.B. bei von Hippel & Tippelt, 2009; Kauffeld, 2016), wird aber bei der Evaluation von Programmimplementationen selten diskutiert (Ausnahme: Beelmann & Karing, 2014).

- (Fach)politischer Rückhalt: Zur Implementation von Maßnahmen ist neben einer empirischen und theoretischen Fundierung der Intervention ein Rückhalt zumindest durch kommunale, besser durch überregionale administrative Vorgaben zur Unterstützung der "Reform" hilfreich, wenn nicht gar notwendig (Beelmann & Karing, 2014, S. 135; Durlak & Du Pree, 2008; Hasselhorn et al., 2014, S. 141).

Zusammenfassend lässt sich feststellen, dass als zentraler Faktor im Implementationsprozess eine sorgfältige Zielgruppenorientierung, d.h. im Besonderen die Passung zwischen Intervention und den jeweiligen AdressatInnen identifiziert werden konnte. Es stellt sich entsprechend die Frage, inwieweit es aktuell geförderten Projekten bereits gelingt, den o.g. zwölf Kriterien gerecht zu werden, und wie sich dies entsprechend auf die Ergebnisse der jeweiligen Projekte auswirkt. Zu beachten ist, dass die aufgeführten Kriterien nicht unabhängig voneinander sind, so gibt es z.B. einen Zusammenhang zwischen den Merkmalen der Einrichtung und der Motivation der Zielgruppe.

3.2 Der "Umsetzungsindex" als Instrument zur Erfassung der Umsetzungsintensität und Passung/Zielgruppenorientierung

Zur Analyse von Wirkungen und Wirkungszusammenhängen ist eine Kombination von summativer Evaluation in Form von sorgfältigen prä-/post-Messungen und Prozessevaluation sinnvoll, ja unabdingbar. Dazu müssen Ergebnis- und Prozessdaten systematisch in Beziehung gesetzt werden. Eine Möglichkeit hierzu stellt der Umsetzungsindex (UI) dar:

Der UI ist ein Instrument, das im Zentrum für Kinder- und Jugendforschung an der Evangelischen Hochschule Freiburg entwickelt und in verschiedenen Studien zur Erfassung der Umsetzungsintensität einer (komplexen) Maßnahme eingesetzt wurde (Fröhlich-Gildhoff, Kerscher-Becker, et al., 2014; Fröhlich-Gildhoff et al., 2017; Tinius et al., 2017); aber auch Merkmale der Zielgruppen-/Teilnehmerorientierung bzw. Passung einer Maßnahme kann mit erfasst und somit zugänglich für die Analyse gemacht werden. Der UI erlaubt es, die empirisch erfassten Ergebnisse einer Intervention - z.B. die Unterschiede in standardisierten Tests bei der vorher-/nachher-Messung - in ein Verhältnis zu relevanten Faktoren im Umsetzungs-/Implementationsprozess zu setzen. Der UI ist damit von der Grundintention eine Möglichkeit, relevante Prinzipien der Implementationsforschung zu operationalisieren.

Der UI wird erstellt, indem der Umsetzungsprozess - z.B. eines Programms zur Resilienzförderung in Kindertageseinrichtungen - jeweils aus drei Perspektiven (a. Steuerungsverantwortliche/r der beteiligten Institution, bspw. Kitaleitung; b. WeiterbildnerIn/ProzessbegleiterIn/ReferentIn, der/die an der Institution an der Implementation der Maßnahme beteiligt war; c. weitere/r Projektverantwortliche/r) bewertet wird. Insgesamt erfasst der Umsetzungsindex zwölf Indikatoren, deren Umsetzungsgrad auf einer vierstufigen Skala eingeschätzt wird (0 = "nicht", 1 = "wenig", 2 = mittel", 3 = "stark" -> max. 36 Punkte): (1) Funktionsfähigkeit und Bedeutung der institutsinternen Steuerungsgruppe für die Intervention, (2) Begleitung des Umsetzungsprozesses durch die Einrichtungsleitung, (3) Unterstützung des Umsetzungsprozesses durch den Träger, (4) Teilnahme der Zielgruppe (z.B. pädagogische Fachkräfte) an den angebotenen Fortbildungen, (5) Veränderung der Bedeutung des Interventionsthemas (z.B. Resilienz) im Kita-Leben (z.B. Thema auf Teambesprechungen) (6) Umsetzung der Programmbestandteile in den Kindergruppen (Kursprogramm o.ä.), (7) Erfassbare Indikatoren für die Umsetzung des Interventionsthemas im pädagogischen Alltag, (8) Einbezug weiterer Gruppen (z.B. der Eltern), (9) Konzeptionelle Verankerung der Programmziele (z.B. in der Kita-Konzeption), (10) Aktivitäten zur externen Vernetzung bzgl. des Interventionsthemas, (11) Anzeichen zur Sicherung der Nachhaltigkeit, (12) "Störung" des Umsetzungsprozesses durch andere Projekte/Aktivitäten (z.B. parallele QE-Prozesse). Aus den Ergebnissen der Bewertung der Indikatoren aus den drei Perspektiven wird der Mittelwert gebildet. Auf dieser Grundlage kann eine Rangreihe der beteiligten Einrichtungen gebildet werden und diese mit der Rangreihe der summativen Evaluationsergebnisse (z.B. prä-post-Differenzen in standardisierten Tests) verglichen werden. Auf diese Weise können Bezüge zwischen Umsetzungsintensität und Ergebnismaßen hergestellt und Hinweise für die Wirksamkeit der Intervention identifiziert werden. Es wäre ebenfalls denkbar, allerdings mit erhöhtem Aufwand, die so erfassten multiperspektivischen Maße durch eine noch differenziertere inhaltsanalytische Auswertung in Kombination mit weiteren qualitativen Methoden (s. den folgenden Abschnitt 3.3) zu verwenden, um zu analysieren, inwieweit in den unterschiedlichen Phasen der durchgeführten Maßnahme eine "Passung" zwischen Maßnahme und Zielgruppe vorlag.

3.3 Gezielter Einsatz qualitativer Methoden zum Erfassen von Veränderungen bei quasi-experimenteller Bedingungsvariation

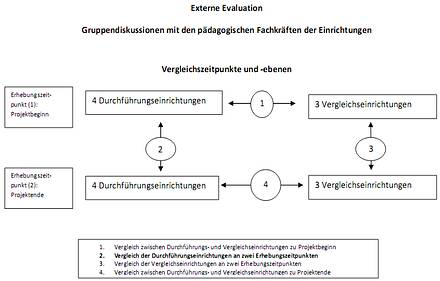

Im Rahmen eines Projekts zur Resilienzförderung in Kindertageseinrichtungen in sozial belasteten Quartieren (Fröhlich-Gildhoff et al., 2011, Fröhlich-Gildhoff & Rönnau-Böse, 2012) wurden mögliche Wirkungen durch ein Vergleichsgruppendesign mit quantitativen Methoden (standardisierte Testverfahren; prä-post-Messung; Randomisierung war nicht möglich) erfasst. Eine potenzielle Einflussvariable stellen bei Interventionen in Kitas die "Haltungen" (handlungsleitende Orientierungen) der pädagogischen Fachkräfte dar. Diese wurden durch eine externe Evaluation, die prozessbegleitend angelegt war, mittels Gruppendiskussionen mit den pädagogischen Fachkräften der beteiligten vier Durchführungs- und drei Vergleichseinrichtungen erfasst (Nentwig-Gesemann, 2011). Die Gruppendiskussion ist ein offenes Verfahren der qualitativen Sozialforschung, das es ermöglicht, konkrete Erfahrungen und Erlebnisse zu erfassen, die Eigendynamik und Eigensinnigkeit von Projektpraxis zu verstehen und die Veränderung von Orientierungen und Deutungen zu rekonstruieren (vgl. Bohnsack, 2003). Insgesamt wurden 14 Gruppendiskussionen durchgeführt, jeweils sieben zu Projektbeginn und Projektende mit den Teams der vier Durchführungs- und drei Vergleichsgruppeneinrichtungen). Diese Forschungsanlage ermöglichte sowohl querschnittliche als auch längsschnittliche Vergleiche zwischen Durchführungs- und Vergleichseinrichtungen und auch innerhalb der jeweiligen Gruppe im Hinblick auf Veränderungen über die Projektzeit; es waren mithin vier Vergleiche möglich:

- Abbildung 2: Design einer qualitativen Wirkungsanalyse (Nentwig-Gesemann, 2011)

Die Analyse der Gruppendiskussionen zeigte deutliche Änderungen der "Haltungen" der Fachkräfte in den Durchführungsgruppen über den Projektverlauf hinweg, die sich in den Vergleichsgruppen nicht rekonstruieren ließen (Nentwig-Gesemann, 2011). Diese Ergebnisse ließen sich dann wiederum mit den quantitativen Daten verbinden, und es ergaben sich vertiefte Erkenntnisse zu Wirkungszusammenhängen und -mechanismen.

3.4 Kontrollierte Einzelfallstudien

Kontrollierte Einzelfallstudien werden zwar in Methoden-Lehrbüchern immer wieder als probate Mittel der Wirkungsforschung benannt (z.B. Bortz & Döring, 2006), jedoch sehr selten realisiert. Das experimentelle Design der Einzelfallstudie wird nach Fichtner (1996, S. 61) als "ein planvolles und replizierbares Verfahren [definiert], bei dem durch systematische Variation der unabhängigen Variable (Intervention) und Konstanthaltung anderer Bedingungen die Veränderungen der abhängigen Variable im zeitlichen Verlauf über zahlreiche Messzeitpunkte [bei je einer Person] registriert werden". Viele Messzeitpunkte können mögliche Veränderungen auf der Ebene des Individuums abbilden und diese wiederum mit der Intervention - z.B. gezielten pädagogischen Begegnungsformen oder psychotherapeutischen Maßnahmen - in Verbindung bringen. "Die Einzelfallanalyse ist einem Gruppenvergleich (...) überlegen, wenn der idiographische Aspekt im Vordergrund stehen soll. Komplexität, Komorbidität, eine ganzheitliche Sicht des Subjekts sowie der historisch-lebensgeschichtliche Hintergrund des analysierten Falles sind dabei von Interesse (Kazdin, 2010)" (Kornberger & Yanagida, 2017, S. 363). Bei den Einzelfallstudien sind der Einsatz standardisierter Instrumente, eine Kombination aus quantitativen und qualitativen Methoden sowie ein multiperspektivisches Herangehen neben der systematischen Bedingungsvariation von besonderer Bedeutung, um die interne Validität zu sichern (Brunstein & Julius, 2014).

Kornberger & Yanigada (2017) stellen das "multiple-baseline Design" vor, bei dem "dieselbe Intervention in verschiedenen, voneinander unabhängigen Zeitreihen zum Einsatz" kommt (ebd., S. 363). Eine (Verhaltens-)Veränderung sollte dann nur auftauchen, wenn die Intervention durchgeführt wird: "The multiple-baseline design demonstrates the effect of an intervention by showing that behavior changes when and only when the intervention is applied. (...) The pattern of results illustrates that whenever the intervention is applied, behavior changes" (Kazdin, 2011, S. 145). Wenn sich derselbe Wirkmechanismus bei mehreren Personen zeigt, so kann von einer guten Generalisierbarkeit der Ergebnisse ausgegangen werden.

Ein gelungenes Beispiel für systematische Einzelfallstudien stammt aus einem anderen Fachgebiet: Mit dem Ansatz der "integrativen Einzelfallstudien" kombiniert Schubert (Schubert et al., 2012; Schubert, 2015) bei Einzelpersonen sehr systematisch die tägliche Erhebung körperlicher Daten mit psychologischen Maßen (Tests, Interviews), um Aussagen über den Zusammenhang zwischen Stresserleben, Persönlichkeitsfaktoren und körperlichen Verarbeitungsprozessen treffen und so das Geschehen der psycho-neuro-immunologischen Prozesse rekonstruieren zu können.

4 Fazit

Forschung in sozialwissenschaftlichen Zusammenhängen, in der Pädagogik und im Bereich der Prävention muss sich mit der Frage der Wirkungen des (professionellen) Handelns, aber auch spezifizierter Interventionen befassen. Dabei ist das Prinzip der klassischen Evidenzbasierung, die ausschließlich RCT-Studien zulässt, kritisch zu sehen. Trotz dieser Schwierigkeiten besteht die Notwendigkeit, empirisch gegründetes Wissen über die je feld- und professionsspezifischen Handlungs- und Begegnungsformen zu generieren, die als wirksam im Sinne der intendierten Ziele gelten dürfen. Im Sinne von Mischo (2017, S. 76f) geht es darum, "dass die beste (zu einer bestimmten Zeit) verfügbare Forschungsevidenz sowie auch das erfahrungsbasierte Wissen der Beteiligten (z.B. Fachkräfte und Eltern) und Werte/Werthaltungen integriert und herangezogen werden, um handlungsbezogene Entscheidungen zu begründen (Buysse et al., 2006). Mit diesem Konzept wird auch der jeweils individuellen Entscheidungssituation und ihren kontextuellen Bedingungen Rechnung getragen, die eine nomothetische, d.h. auf verallgemeinernde Gesetzmäßigkeiten abzielende Forschung nicht berücksichtigen kann".

Das in Medizin und Psychologie vorherrschende Prinzip der RCT-Designs ist für die Erforschung komplexer Zusammenhänge in Praxiskontexten ungeeignet. Aus diesem Grund müssen andere Formen der Erfassung von Veränderungen und Wirkungen genutzt werden. Im Besonderen ist bei Wirkungsstudien das Verhältnis von interner und externer Validität auszubalancieren: Wirksamkeitsstudien müssen einem klar nachvollziehbaren, systematischen Vorgehen in Durchführung, Datenerfassung und -auswertung folgen und sollten Zusammenhänge zwischen Intervention und Ergebnis sichtbar machen. Zugleich müssen sie aber auch gegenstandsangemessen sein. Dies führt zur Notwendigkeit, vorhandene und möglicherweise Einfluss nehmende Variablen in der prä- und post-Messung, aber auch im Verlauf des Interventionsprozesses breit zu erfassen. Generell bedarf es hierzu methodisch sorgfältig kontrollierter Kombinationen von summativer Evaluation und Prozessevaluation mit einer Kombination aus quantitativen und qualitativen Methoden (z.B. Cresswell, 2003; s.a. Fröhlich-Gildhoff & Nentwig-Gesemann, 2008). Die methodologische Diskussion sollte hierzu intensiviert und der vielversprechende Ansatz der kontrollierten Einzelfallanalysen/-studien auch im früh-/kindheitspädagogischen Bereich etabliert werden.

Endnote- Dieser Beitrag ist eine überarbeitete und aktualisierte Fassung des Artikels von Fröhlich-Gildhoff & Hoffer, 2017.

Literatur

Ahrbeck, B., Ellinger, S., Hechler, O., Koch, K. & Schad, G. (2016). Evidenzbasierte Pädagogik. Sonderpädagogische Einwände. Stuttgart: Kohlhammer.

Albus, S. & Micheel, H.-G. (2012). Entmündigung der Praxis? In K. Unzicker & G. Hessler (Hrsg.), Öffentliche Sozialforschung und Verantwortung für die Praxis (S. 179-197). Wiesbaden: Springer VS.

Baldwin, T. & Ford, J. K. (1988). Transfer of training: A review and directions for future research. Personnel Psychology, 41 (1), 63-105.

Beelmann, A. & Karing, C. (2014). Implementationsfaktoren und -prozesse in der Präventionsforschung: Strategien, Probleme, Ergebnisse, Perspektiven. Psychologische Rundschau, 65 (3), 129-139.

Bohnsack, R. (2003). Gruppendiskussion. In U. Flick, E. von Kardorff & I. Steinke (Hrsg.), Qualitative Forschung. Ein Handbuch. (2. Aufl., S. 369-384). Reinbek b. Hamburg: Rowohlt.

Bortz, J. & Döring, N. (2006). Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler. Berlin: Springer.

Brunstein, C. & Julius, H. (2014). Evaluation von Interventionen durch Einzelfallstudien. In G. W. Lauth, M. Grünke & J. Brunstein (Hrsg.), Interventionen bei Lernstörungen. Förderung, Training und Therapie in der Praxis (2., überarb. und erw. Aufl., S. 119-138). Göttingen: Hogrefe.

Bundesministerium für Familie, Senioren, Frauen und Jugend (BMFSFJ) (Hrsg.) (2000). Handbuch zur Neuen Steuerung in der Jugendhilfe. Stuttgart: Kohlhammer.

Buysse, V., Wesley, P. W., Snyder, P., & Winton, P. J. (2006). Evidence-Based Practice: What Does It Really Mean for the Early Childhood Field? Young Exceptional Children, 9(4), 2-11.

Cresswell, J. W. (2003). Research Design. Qualitative, Quantitative and Mixed Methods Approaches. Thousend Oaks: Sage.

Di Blasi, Z., Harkness, E., Ernst, E., Georgiou, A. & Kleijnen, J. (2001). Influence of context effects on health outcomes: a systematic review. Lancet, 357 (9258), 757-762.

Durlak, J. A. & DuPre, E. (2008). Implementation Matters: A Review of Research on the Influence of Implementation on Program Outcomes and the Factors Affecting Implementation. American Journal of Community Psychology, 41 (3-4), 327-350.

Fichtner, M. M. (1996). Versuchsplanung experimenteller Einzelfalluntersuchungen in der Psychotherapieforschung. In F. Petermann (Hrsg.), Einzelfallanalyse (S. 61-79). München: Oldenbourg.

Flösser, G. & Otto, H.-U. (Hrsg.) (1996). Neue Steuerungsmodelle für die Jugendhilfe. Neuwied: Luchterhand.

Fröhlich-Gildhoff, K. & Hoffer, R. (2017). Methodische und methodologische Herausforderungen der Wirkungsforschung unter Praxisbedingungen in der Frühpädagogik - Lösungen jenseits des "Goldstandards". In I. Nentwig-Gesemann & K. Fröhlich-Gildhoff (Hrsg.), Forschung in der Frühpädagogik X. Zehn Jahre frühpädagogische Forschung - Bilanzierungen und Reflexionen (S. 209-228). Freiburg: FEL.

Fröhlich-Gildhoff, K., Rauh, K., Kassel, L., Tschuor, S., von Hüls, B., Döther, S. & Schopp, S. (2017). Zwischenbericht der Evaluation des Gesamtprojekts "Präventionsnetzwerk Ortenaukreis", gefördert vom BMBF in der Förderlinie GeDiReMo, Förderkennzeichen: 02K12B051. Freiburg: Zentrum für Kinder- und Jugendforschung an der Evangelischen Hochschule Freiburg. Verfügbar unter: http://www.zfkj.de/images/Zwischenbericht_der_Evaluation_des_Gesamtprojekts.pdf [11.02.2020].

Fröhlich-Gildhoff, K., Nentwig-Gesemann, I., Pietsch, S., Köhler, L. & Koch, M. (2014). Kompetenzentwicklung und Kompetenzerfassung in der Frühpädagogik. Konzepte und Methoden. Freiburg: FEL.

Fröhlich-Gildhoff, K., Kerscher-Becker, J., Rieder, S., von Hüls, B. & Hamberger, M. (2014). Grundschule macht stark! Resilienzförderung in der Grundschule - Prinzipien, Methoden und Evaluationsergebnisse. Freiburg i.Br.: FEL Verlag.

Fröhlich-Gildhoff, K. (2012). Forschung in der Frühpädagogik in Deutschland - Geschichte, Stand und Standards - oder: Von den Moden zu empiriebasiertem und profiliertem Handeln. In S. Kägi & U. Stenger (Hrsg.), Forschung in Feldern der Frühpädagogik (S. 26-58 ). Baltmansweiler: Schneider Verlag Hohengehren.

Fröhlich-Gildhoff, K. & Rönnau-Böse, M. (2012). Prevention of exclusion: the promotion of resilience in early childhood institutions in disadvantaged areas. Journal of Public Health, 20 (2), 131-139.

Fröhlich-Gildhoff, K., Beuter, S., Fischer, S., Lindenberg, J. & Rönnau-Böse, M. (2011). Förderung der seelischen Gesundheit in Kitas für Kinder und Familien mit sozialen Benachteiligungen. Freiburg i.Br.: FEL.

Fröhlich-Gildhoff, K. & Nentwig-Gesemann, I. (2008). Forschung in der Frühpädagogik Sinn - Standards - Herausforderungen. In K. Fröhlich-Gildhoff, I. Nentwig-Gesemann, & R. Haderlein, R. (Hrsg.), Forschung in der Frühpädagogik. Band 1 (S. 13-36). Freiburg i.Br.: FEL.

Gräsel, C. & Parchmann, I. (2004). Implementationsforschung - oder: der steinige Weg, Unterricht zu verändern. Unterrichtswissenschaft, 32 (3), 196-214.

Grimshaw, J., Eccles, M., Thomas, R., MacLennan, G., Ramsay, C., Fraser, C., & Vale, L. (2006). Toward Evidence-Based Quality Improvement: Evidence (and its Limitations) of the Effectiveness of Guideline Dissemination and Implementation Strategies 1966-1998. Journal of General Internal Medicine, 21 (Suppl 2), 14-20. DOI 10.1111/j.1525-1497.2006.00357.x

Grossman, R. & Salas, E. (2011). The transfer of training: what really matters. International Journal of Training and Development, 15 (2), 103-120.

Hasselhorn, M., Köller, O., Maaz, K. & Zimmer, K. (2014). Implementation wirksamer Handlungskonzepte im Bildungsbereich als Forschungsaufgabe. Psychologische Rundschau, 65 (3), 140-149.

Hense, J. & Mandl, H. (2011). Wissensmanagement und Evaluation. Zeitschrift für Evaluation, 10 (2), 267-301.

Hippel, A. von & Tippelt, R. (Hrsg.) (2009). Fortbildung der WeiterbildnerInnen - eine Analyse der Interessen und Bedarfe aus verschiedenen Perspektiven. Weinheim: Beltz.

Hoffer, R. (2014). Transfer in der kompetenzorientierten Weiterbildung für Kita-Leitungen. In Deutsches Jugendinstitut/Weiterbildungsinitiative Frühpädagogische Fachkräfte (Hrsg.), Leitung von Kindertageseinrichtungen. Grundlagen für die kompetenzorientierte Weiterbildung, Band 10 (S. 194-232). München: DJI.

Hoffmann, H., Kubandt, M., Lotte, J., Meyer, S. & Nolte, D. (2014). Professionelle Praxis im Spannungsfeld von evidenzbasiertem Wirken und Handeln in ungewissen Situationen - empirische Plausibilisierungen und Transferperspektiven. In K. Fröhlich-Gildhoff, I. Nentwig-Gesemann & N. Neuß (Hrsg.), Forschung in der Frühpädagogik - Band 7. Schwerpunkt: Profession und Professionalisierung (S. 47-79). Freiburg i.Br.: FEL.

Honig, M.-S. (2002). Perspektiven frühpädagogischer Forschung. Drei Beiträge zur Frühpädagogik. Arbeitspapiere des Zentrums für sozialpädagogische Forschung der Universität Trier. Arbeitspapier II-01, Mai 2002. Trier.

Holzkamp, K. (1972). Zum Problem der Relevanz psychologischer Forschung für die Praxis. In K. Holzkamp, Kritische Psychologie (S. 9-34). Frankfurt a.M.: Fischer.

Holzkamp, K. (1977). Die Überwindung der wissenschaftlichen Beliebigkeit psychologischer Theorien durch die kritische Psychologie. Zeitschrift für Sozialpsychologie, 8 (1), 1-22.

Kauffeld, S. (Hrsg.) (2016). Nachhaltige Personalentwicklung und Weiterbildung. Betriebliche Seminare und Trainings entwickeln, Erfolge messen, Transfer sichern (2., überarb. Aufl.). Berlin: Springer.

Kazdin, A.E. (2010). Research designs in clinical psychology (4th ed.). Boston, IL: Ally & Bacon.

Kazdin, A.E. (2011). Single-case research designs. Methods for clinical and applied settings (2nd ed.). New York: Oxford University Press.

Kolip, P. (2006). Evaluation, Evidenzbasierung und Qualitätsentwicklung. Zentrale Herausforderungen für Prävention und Gesundheitsförderung. Prävention und Gesundheitsförderung, 1 (4), 234-239.

Kornberger, M. & Yanigada, T. (2017). Nomothetischer oder idiografischer Zugang in der Psychotherapieforschung. Randomized controlled trial oder kontrollierte Einzelfallanalyse. Verhaltenstherapie und Psychosoziale Praxis, 49 (2), 359-370.

Michie, S., Jochelson, K., Markham, A. & Bridle, C. (2009). Low-income groups and behaviour change interventions: a review of intervention content, effectiveness and theoretical frameworks. Journal of Epidemiology and Community Health, 63 (8), 610-622. DOI 10.1136/jech.2008.078725.

Mischo, C. (2017). Die Professionalisierung der Professionalisierungsforschung in der Kindheitspädagogik. In I. Nentwig-Gesemann & K. Fröhlich-Gildhoff (Hrsg.), Forschung in der Frühpädagogik X. Zehn Jahre frühpädagogische Forschung - Bilanzierungen und Reflexionen (S. 59-84). Freiburg: FEL.

Mittag, W. (2014). Qualitätssicherung von Präventions- und Interventionskonzepten aus Sicht der Interventions-, Implementations- und Evaluationsforschung. Wirtschaftspsychologie, 16 (2), 50-58.

Nentwig-Gesemann, I. (2011). Ergebnisse der externen Evaluation. In K. Fröhlich-Gildhoff, S. Beuter, S. Fischer, J. Lindenberg & M. Rönnau-Böse (Hrsg.), Förderung der seelischen Gesundheit in Kitas für Kinder und Familien mit sozialen Benachteiligungen (S. 113-130). Freiburg i.Br.: FEL.

Otto, H. U. (2007). Zum aktuellen Diskurs um Ergebnis und Wirkung im Feld der Sozialpädagogik und Sozialarbeit - Literaturvergleich nationaler und internationaler Diskussion. Expertise im Auftrag Auftragsgemeinschaft für Kinder- und Jugendhilfe (AGJ). Berlin: Eigendruck der AGJ.

Petermann, F. (2014). Implementationsforschung: Grundbegriffe und Konzepte. Psychologische Rundschau, 65 (3), 122-128.

Porzsolt, F., Eisemann, M., Habs, M. & Wyer, P. (2013). Form Follows Function: Pragmatic Controlled Trials (PCTs) Have to Answer Different Questions and Require Different Designs than Randomized Controlled Trials (RCTs). Zeitschrift für Gesundheitswissenschaften, 21 (3), 307-313.

Proctor, E.K., Landsverk, J., Aarons, G., Chambers, D., Glisson, C. & Mittman, B. (2009). Implementation Research in Mental Health Services: an Emerging Science with Conceptual, Methodological, and Training challenges. Administration and Policy in Mental Health, 36 (1), 24-34.

Schubert, C. (2015). Einfluss von frühen psychischen Belastungen auf die Entwicklung von Entzündungskrankheiten im Erwachsenenalter. In C. Schubert (Hrsg.), Psychoneuroimmunologie und Psychotherapie (2. Aufl., S. 117-140). Stuttgart: Schattauer.

Schubert, C., Geser, W., Noisternig, B., Fuchs, D., Welzenbach, N. & König, P. (2012). Stress System Dynamics during "Life As It Is Lived”: An Integrative Single-Case Study on a Healthy Woman. PLoS ONE, 7 (3): e29415. Verfügbar unter: http://journals.plos.org/plosone/article?id=10.1371/journal.pone.0029415 [11.02.2020]. DOI 10.1371/journal.pone.0029415

Stockmann, R. (Hrsg.) (2006). Evaluationsforschung: Grundlagen und ausgewählte Forschungsfelder (Sozialwissenschaftliche Evaluationsforschung). Münster: Waxmann.

Tinius, C., Rönnau-Böse, M. & Fröhlich-Gildhoff, K. (2017). Verbundprojekt zum Thema "Herausforderndes Verhalten in der Kindertageseinrichtung" Abschlussbericht. Freiburg i.Br.: Zentrum für Kinder- und Jugendforschung an der Evangelischen Hochschule Freiburg, www.zfkj.de. Wampold, B.E. (2001). The great psychotherapy debate. Models, methods and findings. Mahwah, NJ: Erlbaum.

Wirtz, M. A. (2014). Evidenzbasierung. In M. A. Wirtz (Hrsg.), Dorsch - Lexikon der Psychologie (18. Aufl., S. 536). Göttingen: Hogrefe.

Ziegler, H. (2010). Ist der experimentelle Goldstandard wirklich Gold wert für eine Evidenzbasierung der Praxis Früher Hilfen? Bundesgesundheitsblatt, 53 (10), 1060-1066.

Autor*innen

Rieke Hoffer

Zentrum für Kinder- und Jugendforschung

an der Evangelischen Hochschule Freiburg

Buggingerstr. 38

79114 Freiburg

rieke.hoffer@bitte-keinen-spam-eh-freiburg.de

Dipl. Psych., Kinder- und Jugendlichenpsychotherapeutin, hauptamtl. Dozentin an der Evangelischen Hochschule Freiburg

Prof. Dr. Klaus Fröhlich-Gildhoff

froehlich-gildhoff@bitte-keinen-spam-eh-freiburg.de

Dipl.Psych., Psychologischer Psychotherapeut und Kinder- und Jugendlichenpsychotherapeut, Co-Leiter des Zentrums für Kinder- und Jugendforschung an der Evangelischen Hochschule Freiburg

|